データエンジニア

Freelance

on 2025-03-24

86 views

0 requested to visit

最先端AI×データ基盤で広告SaaS・キャリアを革新!データエンジニア募集

Freelance

REHATCH株式会社's members

座右の銘:2度とない人生だから。念ずれば花開く。

#甲子園球児#船井総合研究所コンサルタント#ユーザベースのFORCAS

What we do

経営者やマーケターの意思決定を支えるべく、SaaS×マーケコンサルを掛け合わせた事業を展開。

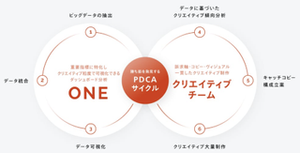

あらゆるデータを統合し、中長期的な売上最大化の実現を目指して開発された、事業をドライブさせる広告BIプラットフォーム「ONE」

REHATCHは、「意思決定で、世界をうごかす。」をビジョンに掲げ、多様な分野でイノベーションを生み出し、戦略的M&Aを通じて世界に変革をもたらす企業です。

◇ 採用資料はこちら:https://t.ly/tQEBk

現在は以下の事業を行っております。

▍事業①:クライアントの事業をドライブさせるデータ統合プラットフォーム『ONE』

クライアントのマーケティングデータと顧客データを融合させ、改善策をレコメンドする自社開発SaaSです。クライアントの利益向上に直結する指標に合わせてカスタマイズして提供しています。最新機能には、認知施策の売上への貢献度を計るアトリビューション分析が含まれています。

https://re-hatch.jp/service-one/

▍事業②:マーケティンググロースパートナー事業

企業の売上や利益を最大化するための徹底的な課題分析を行い、マーケティング施策の立案から実行、分析までをワンストップでサポートします。2024年3月にはインフルエンサー事業を買収、また近年トレンドになっている縦型動画の新規ソリューションを2024年5月にリリース予定と、顧客の多様なニーズに応えるためのサービス展開も進めています。

https://re-hatch.jp/service-marketing/

▍事業③:次世代リーダーのためのキャリア開発プラットフォーム『LEAPLACE』

『LEAPLACE』は、次世代リーダーのためのキャリア開発支援を専門とするプラットフォームです。単なる転職サイトを超え、本人の成長したい方向性を定めることで、今後のキャリア選択肢を提案します。

https://leaplace.jp/

_________________________________________

Why we do

REHATCH VISION「意思決定で、世界をうごかす。」

経営者が300人以上集まるカンファレンスに何度も登壇

▍ VISION

意思決定で、世界をうごかす。

▍ MISSION

世界一のイノベーションカンパニーになる。

▍ タグライン

その手に、勝てる選択を。

▍ VALUES

01 最高の1日にしよう。

02 道がなければうみだそう。

03 ユニークに突き抜ける。

04 TEAM REHATCH

05 そこにサプライズはあるか。

1日に人間が意思決定する回数は3.5万回。一人ひとりが後悔のない人生にするためには、一つ一つの意思決定を豊かにすることが最も重要です。

「REHATCH」の社名は、 再発明という意味が込められています。我々は多事業での再発明を通して、あらゆる意思決定を豊かにしていきます。

_________________________________________

How we do

前職で成果を出してきた少数精鋭のメンバーで構成

海外でのチームビルディング inバリ

▍ メンバー

-少数精鋭(正社員15名、業務委託、学生インターン)

- リクルート、サイバーエージェント、ユーザベース、アビームコンサルティングetc…

◇ CEO迫田-創業ストーリー

https://www.wantedly.com/companies/company_5515343/post_articles/324195

◇ COO山崎-インタビュー

https://www.wantedly.com/companies/company_5515343/post_articles/341319

▍ バリュー・文化

REHATCHの5バリュー

01 最高の1日にしよう。

02 道がなければうみだそう。

03 ユニークに突き抜ける。

04 TEAM REHATCH

05 そこにサプライズはあるか。

その他、情熱と論理の両方を重視。

主体性は必須。手を上げるものに裁量権のある仕事を任せる。

▍ 制度

- フルフレックス制度

- リモートワークとリアルのハイブリット

- ワーケーション合宿あり:沖縄や京都など

- 表彰イベントあり:「はっち祭」「メンバー感謝祭」「周年祭」など

- 達成旅行:2023年度は社員全員でバリ旅行へ!

▍ 実績

◇ 2023年度「ベストベンチャー100🏆」に選出

~~~「ベストベンチャー100」とは~~~

これから成長が期待されるベンチャー企業100社限定のサイトで、『ベンチャー通信』を運営するイシン株式会社が提供する法人向け有料会員制サービスになります。イシン株式会社にエントリーした企業の中から、イシン株式会社が厳正な審査のもと選出したベンチャー企業100社が「ベストベンチャー100」として紹介されます。※ サービス概要や審査内容については下記をご参照ください。

ベストベンチャー100について:

https://best100.v-tsushin.jp/about/

エントリーについて:

https://best100.v-tsushin.jp/judge/

_________________________________________

As a new team member

私たちは広告データ分析系SaaSおよびキャリアプラットフォームのさらなる進化を目指し、データ基盤・分析基盤、LLM/AI基盤の構築・運用を強化し、革新的なプロダクトを支えるため、各種データの収集、加工、品質管理に精通したデータエンジニアを募集いたします。最新クラウド環境での即戦力として、企業の革新と成長を共に牽引できる仲間を歓迎いたします。

データ基盤構築、データ分析基盤運用、LLM/AI基盤開発に携わりたい方、ぜひご応募ください。

▼具体的な業務内容

- 各種データソースからのデータ収集、加工、分析

- データパイプラインの設計、構築、運用、改善

- データウェアハウス、データレイクの設計、構築、運用

- データ品質の監視、改善、データガバナンスの実装

▼上記業務に慣れてきたら以下にもトライいただきたいです

- データ分析基盤の構築支援

- データ可視化支援

- ビジネス部門との連携によるデータニーズの把握、データ活用支援

- ドキュメンテーション、技術共有、チームへの貢献

▼開発環境・技術スタック

- バックエンド:Python, Java, Scala

- データパイプライン関連: Airflow, Spark, Flink

- AI関連: LangChain, OpenAI API

- データベース: SQL, PostgreSQL, MySQL, DynamoDB, Firestore

- インフラ: AWS, GCP, Azure

- その他: Tableau, Looker, Power BI

▼このポジションの魅力

- 大規模データ処理やクラウド環境でのデータ基盤構築、最新AI技術(LLMなど)に実践的に携る事が可能

- 生成AIやLLMを活用したエージェント開発に携わり、実際のプロダクトの進化に貢献できる

- 企業の成長に直結するサービスに貢献ができる

- データパイプラインやデータウェアハウスの設計・運用を通じ、企業の意思決定基盤に携わる事が可能

- Python、Node.js、Airflow、Spark、Flink、Tableauなど、多様な技術を駆使してスキルの幅が広げられる

- 自由度の高い開発環境で新しい技術を試せる

- エンジニアリングとプロダクトの両方の視点を養える

- 迅速かつ効率的なアジャイル開発で即座にアイデアを形にできる

- エンジニア同士の学び合いを大切にする環境

▼求めるスキル・経験

◾️必須スキル

-SQLによるデータ抽出、集計の実務経験 (3年以上)

-PythonもしくはNode.jsのプログラミング経験(2年以上)

-クラウド環境 (AWS, GCP, Azure)でのデータ基盤構築、運用経験 (1年以上)

-データパイプライン構築、運用経験 (Airflow, Spark, Flinkなど)

-データ品質に関する知識、データガバナンスに関する知識

-バージョン管理ツール (Gitなど) の利用経験

-アジャイル開発の経験

◾️歓迎スキル

- APIの設計・開発経験(REST, GraphQL)

- GitHubを活用したチーム開発の経験

- AWS/GCPなどクラウド環境での開発・運用経験

- LangChainやGradioを用いた開発経験

- 生成AI(OpenAI API, Claude, Llamaなど)を活用したシステム開発経験

- LLMファインチューニングやデータパイプラインの構築経験

- DevOpsの知識(Docker, CI/CD, Vercel など)

- ノーコード/ローコードツール(Zapier, Difyなど)の活用経験

▼こんな方を歓迎します!

- 新しい技術に興味を持ち、積極的に学習できる方

- データを用いてビジネス課題を解決したい方

- 自律的にタスクを進め、責任感を持って業務に取り組める方

- コミュニケーション能力が高く、チームメンバーと円滑に連携できる方

- ドキュメンテーションを重視し、知識を共有できる方

▼勤務条件

勤務時間:フレックス/リモート可

稼働時間:160h/月(要相談)

*最低時間は80h /月、土日不可

服装:自由

▼学習支援

- AI関連の有料コミュニティや書籍・講座の購入費支援

- 有料LLM APIの試用補助

- AIツール(github Copilot,Cursor,Cline,windsurfなど)補助

▼応募方法

- カジュアル面談も可能です。少しでも興味があれば、お気軽にご応募ください!

1 recommendation

Team Personality Types

Learn about your teammates' personality types

Understand the 16 personality types within Wantedly Assessment and their distinct traits and tendencies

Learn more

Highlighted stories

More from REHATCH株式会社

- デザインにまつわる全般

アイデアを形にし、事業をうごかす。新卒デザイナー募集

- マーケティングコンサルタント

内定直結27卒向け|マーケティングで論理的思考力を身につける長期インターン

- ビジネス職ポジション

26卒募集|イノベーションを創るスタートアップでビジネス職へチャレンジ

What happens after you apply?

- ApplyClick "Want to Visit"

- Wait for a reply

- Set a date

- Meet up

Company info